AI

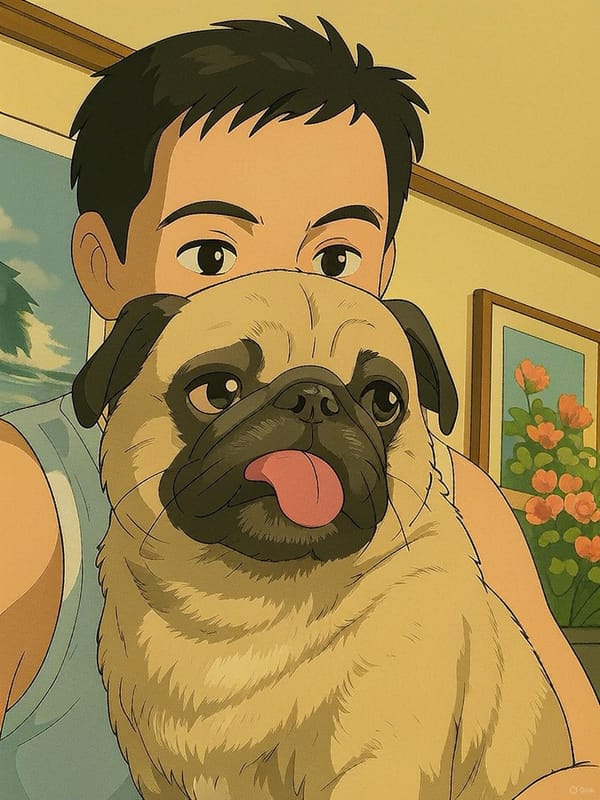

AI로 만드는 지브리 스타일 이미지

chatgpt와 grok을 이용해서 가끔 지브리 스타일의 이미지를 만들어보면 참 따스하다. 내가 하지 못한것을 댜신 해주는 시대. 뭔가 재미난 세상이다.

AMD Ryzen™ 9 5900XT 16-Core, 32-Thread, RTX 3060 12GB, 128G RAM. 512GB+256GB NVME SSD, 8TB HDD

AI

chatgpt와 grok을 이용해서 가끔 지브리 스타일의 이미지를 만들어보면 참 따스하다. 내가 하지 못한것을 댜신 해주는 시대. 뭔가 재미난 세상이다.

AI

AI

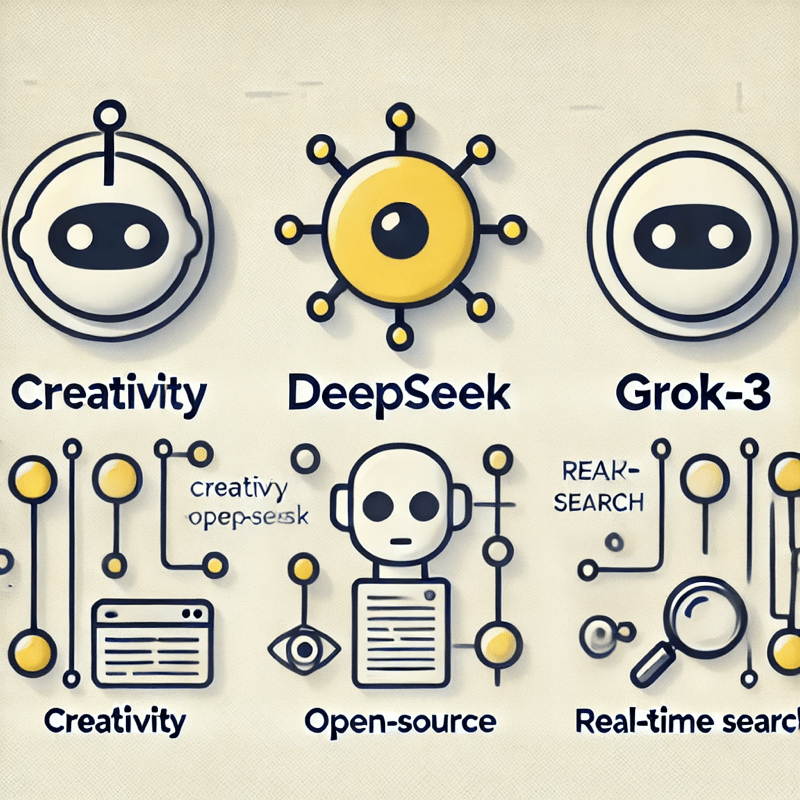

LLM 모델 큰것을 사용하면 정확도가 높아진다고 한다. 뻘소리 하지 않고 좀 더 정확한 대답을 한다는 것이겠다. 그럴려면 GPU 메모리가 커야 한단다. 그래서 24기가 메모리가 장착된 Nvidia 3090이나 4090등이 품귀라고 한다. 전문 gpu 보다 상대적으로 저렴하기 때문이다. 그런데 맥장비 M 시리즈는 통합메모리를 사용하는데 그게 이쪽에서 잇점이 있었다. 예를 들어 M1 max

AI

요즘 대세라고 하는 3가지 LLM 에 대해서 살펴밨다. 개인이 뭔가 이제 자신만의 지식저장고를 만들수도 있을것 같다는 생각이 든다. ChatGPT vs DeepSeek vs Grok-3 비교 분석 현재 AI 모델 시장에서 ChatGPT(OpenAI), DeepSeek, **Grok-3(X/Tesla)**는 주목받는 대형 언어 모델(LLM)입니다. 이 모델들은 각기 다른 철학과 기술적 접근을 가지고

AI

비싼 NVIDIA의 GPU를 사용하는 이유중 하나가 cuda 코어 때문이다. 이 cuda코어를 소프트웨어로 에뮬레이션 할수 있지 않을까 하는 질문에 검색을 해보았다. 결론은 가능 할수도 있지만 속도가 극악이라 사용하기 힘들듯 하다. CUDA 코어나 Tensor 코어를 소프트웨어적으로 에뮬레이션하는 것은 가능하지만, 매우 비효율적이며 일반적으로 실행 속도가 극도로 느려질 수 있습니다. 그래도 몇 가지 방법을

AI

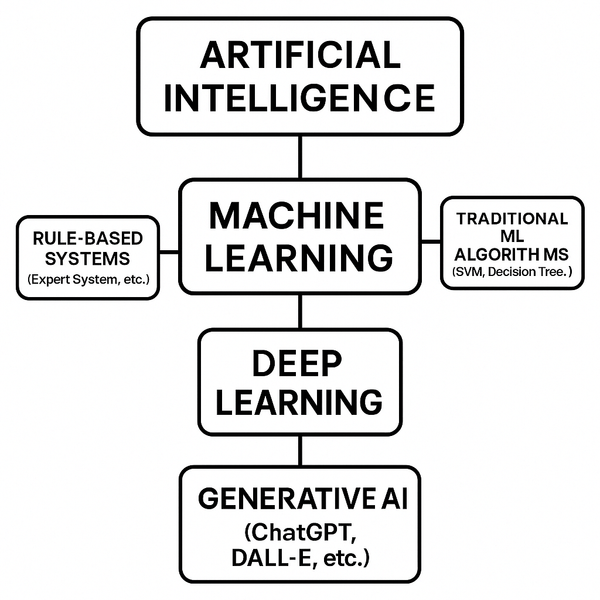

엄밀히 말하자면, **“머신러닝(Machine Learning)”**은 인공지능(AI)의 하위 개념이고, 그 아래에 **“딥러닝(Deep Learning)”**이 위치합니다. 즉, **“인공지능 > 머신러닝 > 딥러닝”**의 계층 구조로 이해할 수 있습니다. 이를 더 자세히 설명하면 다음과 같습니다: 1. 인공지능(AI, Artificial Intelligence) • 최상위 개념으로, 인간의 지능을 모방하는 모든 기술을 포괄합니다. • AI는

AI

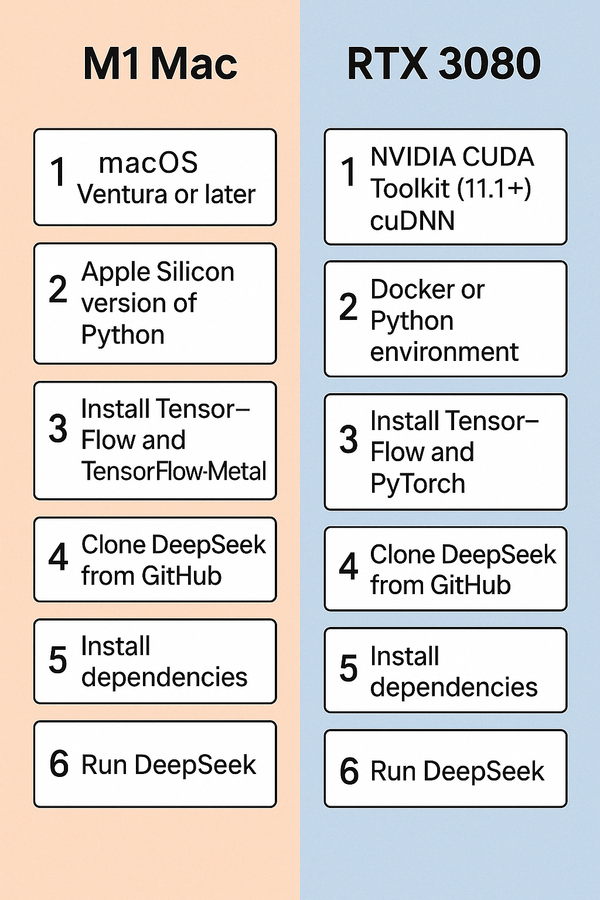

DeepSeek: M1 Mac과 RTX 3080에서 효율적으로 운영하는 방법 DeepSeek은 AI 기반 데이터 분석 및 검색 플랫폼으로, 고성능 하드웨어를 통해 더 빠르고 정확한 작업이 가능합니다. 이 글에서는 Apple M1 칩과 NVIDIA RTX 3080 GPU를 활용해 DeepSeek을 실행하는 방법을 안내합니다. 1. DeepSeek이란? DeepSeek은 머신러닝과 자연어 처리를 결합하여 대규모 데이터 검색과 분석을 수행하는

AI

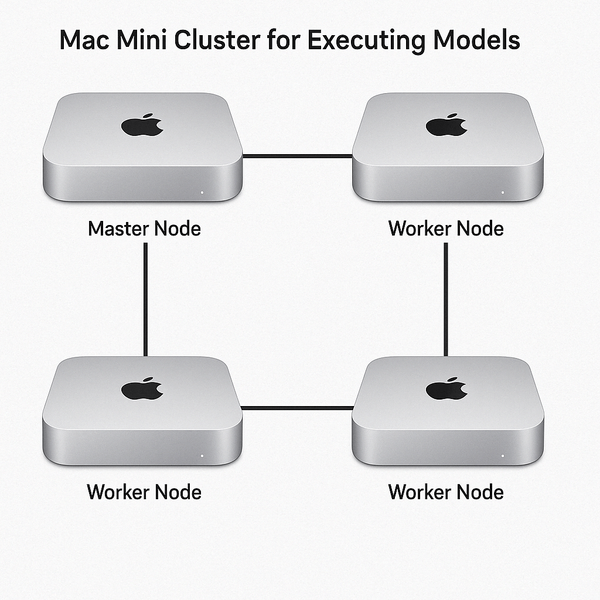

1. Concept of an M1 Mac Cluster with Thunderbolt Although M1 Macs do not offer native clustering functionality like traditional x86 servers, they can leverage Thunderbolt 3/4 ports for high-speed networking. This allows distributed learning using MPI (Multi-Processing Interface). Cluster Networking Options with Thunderbolt: • Thunderbolt-to-Ethernet Bridge: Use Thunderbolt cables

AI

To create a cluster using multiple Mac Minis for executing models like DeepSeek, you can follow these steps: 1. Hardware Setup: • Use multiple M1 Mac Minis with at least 16GB of unified memory. • Connect the Mac Minis using Thunderbolt cables or via a high-speed Ethernet switch to ensure low-latency communication

AI

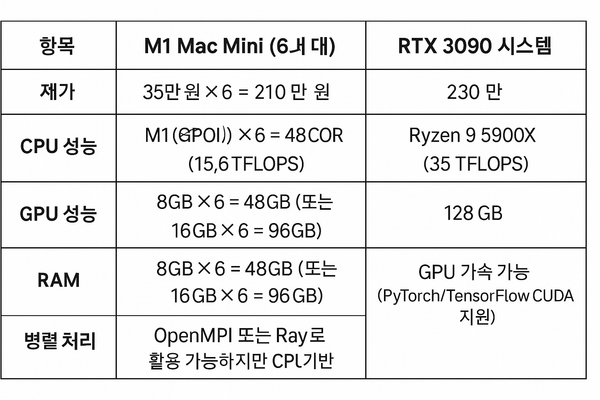

당연히 rtx3090이 성능이 좋을듯하다. 예상은 했지만 수치로 알려주니 좋. DeepSeek(딥러닝 모델) 실행 속도를 비교하려면 컴퓨팅 성능(CPU, GPU, RAM), 병렬 처리 가능 여부, 모델 최적화 상태 등을 고려해야 해. 1. 비교 대상 스펙 • M1 Mac mini (6대) • 가격: 35만 원 × 6 = 210만 원 • CPU: Apple M1 (8코어) • GPU: M1

AI

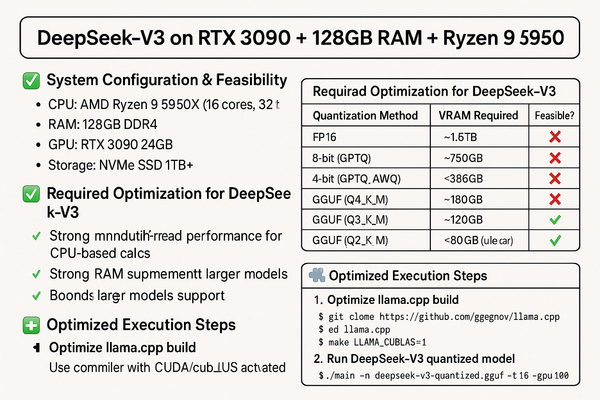

aAMD Ryzen 9 5950X + RTX 3090 (24GB) + RAM 128GB에서 DeepSeek-V3 실행 가능 여부 ✅ AMD Ryzen 9 5950X + RTX 3090 (24GB) + 128GB RAM 환경에서는 DeepSeek-V3의 양자화 버전 실행이 가능합니다. ✅ 다만, llama.cpp를 최적화하여 빌드하고, 적절한 양자화 모델을 선택해야 최상의 성능을 얻을 수 있습니다. 1. 시스템 구성 및 실행 가능성 사용할 하드웨어:

AI

M1 Mac 여러 대를 썬더볼트 케이블을 이용해 클러스터로 구성하고 딥시크(DeepSeek)를 구동하는 방법을 설명해 줄게. 1. 썬더볼트를 이용한 M1 Mac 클러스터 개념 M1 Mac은 일반적인 x86 서버와 달리 본격적인 클러스터링 기능을 제공하지 않지만, 썬더볼트 3/4 포트를 활용한 고속 네트워킹이 가능해 MPI(Multi-Processing Interface) 기반의 분산 학습을 수행할 수