본 게시물은 AI를 활용하여 논문 “CoCoLM: Complex Commonsense Enhanced Language Model with Discourse Relations”에 대한 주요 내용을 요약하고 분석한 결과입니다. 심층적인 정보는 원문 PDF를 직접 참고해 주시기 바랍니다.

📄 Original PDF: Download / View Fullscreen

영문 요약 (English Summary)

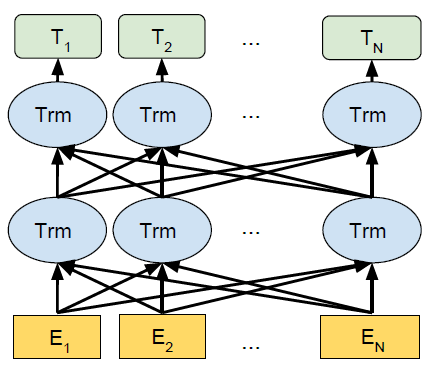

This paper proposes CoCoLM, a novel contextualized language model enhanced by complex commonsense knowledge. The researchers introduce two auxiliary discourse tasks that enable the injection of eventuality-level co-occurrence information into pre-trained LMs through weighted random walk over ASER to harvest multi-hop eventuality sequences connected by discourse relations. CoCoLM achieves stronger performance than baseline LMs on multiple datasets that require understanding of complex commonsense knowledge, making high-order inference over eventualities challenging and fulfilling the requirements for rare events.

한글 요약 (Korean Summary)

이 논문은 복잡한 상식 지식에 의해 향상된 새로운 맥락화 된 언어 모델 인 Cocolm을 제안합니다. 연구원들은 담론 관계에 의해 연결된 다중 hop 사건 시퀀스를 수확하기 위해 가중 무작위 산책을 통해 사전 훈련 된 LMS에 사전 훈련 된 LMS에 대한 사건 수준의 공동 발생 정보를 주입 할 수있는 두 가지 보조 담론 과제를 소개합니다. Cocolm은 복잡한 상식 지식을 이해해야하는 여러 데이터 세트에서 기준 LM보다 더 강력한 성능을 달성하여 희귀 한 사건에 대한 요구 사항에 도전하고 충족하는 고차의 추론을 만듭니다.

주요 기술 용어 설명 (Key Technical Terms)

이 논문의 핵심 개념을 이해하는 데 도움이 될 수 있는 주요 기술 용어와 그 설명을 제공합니다. 각 용어 옆의 링크를 통해 관련 외부 자료를 검색해 보실 수 있습니다.

- Eventuality [Wikipedia (Ko)] [Wikipedia (En)] [나무위키] [Google Scholar] [Nature] [ScienceDirect] [PubMed]

설명: {Concise English Explanation 1} – 담론 분석에 종종 사용되는 행동, 감정, 욕구 등의 관계를 나타내는 체인이나 시퀀스를 설명하는 데 사용되는 언어 용어.

(Original: {Concise English explanation 1} – A linguistic term used to describe chains or sequences that represent relationships among actions, emotions, desires etc., often employed in discourse analysis.) - ASER [Wikipedia (Ko)] [Wikipedia (En)] [나무위키] [Google Scholar] [Nature] [ScienceDirect] [PubMed]

설명: {Concine English Explanation 2} – 기존 지식 그래프 (Zhang et al., 2020b)는 Raw Corpus에서 동시 및 담론 관계를 자동으로 추출합니다. 자동화 된 특성으로 인해 소음이 포함될 수 있습니다.

(Original: {Concine English explanation 2} – An existing knowledge graph (Zhang et al., 2020b) which automatically extracts eventuality and discourse relations from raw corpus; it may contain noise due to its automated nature.) - Weighted Random Walk [Wikipedia (Ko)] [Wikipedia (En)] [나무위키] [Google Scholar] [Nature] [ScienceDirect] [PubMed]

설명: {Concise English Explanation 3} – ASER에 사용 된 기술, 여기서 결국의 가장자리에 기초하여 연결이 가중치를 할당하는 기술 (표 2); 5 개보다 큰 주파수로 시작점을 샘플링하여 드문 이벤트를 필터링하는 데 도움이됩니다.

(Original: {Concise English explanation 3} – A technique used in ASER, where connections are assigned weights based on edges between eventualities (Table 2); helps filter out rare events by sampling starting points with larger frequencies than five.)

원문 발췌 및 번역 보기 (Excerpt & Translation)

원문 발췌 (English Original)

CoCoLM: Complex Commonsense Enhanced Language Model with Discourse Relations Changlong Yu1∗ Hongming Zhang1, 2∗Yangqiu Song1 Wilfred Ng1 1HKUST, Hong Kong, China 2Tencent AI Lab, Seattle, U.S. {cyuaq, yqsong, wilfred}@cse.ust.hk, hongmzhang@tencent.com Abstract Query Answer Birds can [MASK]. fly Large-scale pre-trained language models have Cars are used for [MASK]. transport demonstrated strong knowledge representa- Jim yells at Bob, [MASK] Jim is upset. but tion ability. However, recent studies suggest Jim yells at Bob, [MASK] Bob is upset. but that even though these giant models contain2022 rich simple commonsense knowledge (e.g., bird can fly and fish can swim.), they often Table 1: Exploring knowledge contained in pre-trained struggle with complex commonsense knowl- language models following LAMA (Petroni et al., edge that involves multiple eventualities (verb- 2019). Queries and prediction returned by BERT-largeMay centric phrases, e.g., identifying the relation- are presented. Semantically plausible and implausible prediction are indicated with blue and red colors.26 ship between “Jim yells at Bob” and “Bob is upset”). To address this issue, in this paper, we propose to help pre-trained lan- edge, they often only perform well when the se- guage models better incorporate complex com- monsense knowledge. Unlike direct fine- mantic unit is a single token while poorly when the tuning approaches, we do not focus on a spe- semantic unit is more complex (e.g., a multi-token cific task and instead propose a general lan- named entity or an eventuality, which is a linguis-[cs.CL] guage model named CoCoLM. Through the tic term for verb-centric phrases covering activities, careful training over a large-scale eventual- states and events (Bach, 1986; Araki and Mitamura, ity knowledge graph ASER, we successfully 2018)). For example, as shown in Table 1, if we teach pre-trained language models (i.e., BERT follow LAMA (Petroni et al., 2019) to analyze the and RoBERTa) rich discourse-level common- knowledge…

발췌문 번역 (Korean Translation)

COCOLM : 담론 관계를 가진 복잡한 상식 강화 언어 모델 Changlong Yu1 * Hongming Zhang1, 2 * Yangqiu Song1 Wilfred Ng1 1hkust, Hong Kong, China 2Tencent AI Lab, Seattle, U.S. [마스크]. 대규모 규모의 미리 훈련 된 언어 모델에는 자동차가 [마스크]에 사용됩니다. 교통 수단은 밥에게 강한 지식 대표를 보여 주었다. [마스크] Jim은 화가났다. 그러나 능력. 그러나 최근의 연구에 따르면 Jim은 Bob의 Jim Yells, [Mask] Bob이 화가 났다고합니다. 그러나 이러한 거대한 모델이 2022 풍부한 간단한 상식 지식을 포함하더라도 (예를 들어, 조류는 수영을 할 수 있습니다.), 그들은 종종 표 1 : 라마에 따른 복잡한 상식 지식과 함께 미리 훈련 된 투쟁에 포함 된 지식을 탐구합니다 (Petroni et al., 여러 사건을 포함하는 Edge (Verb- 2019). 관계가 제시됩니다. 이 문제를 해결하기 위해이 논문에서, 우리는 미리 훈련 된 랜 우위를 돕기 위해 제안되며, 이들은 종종 서지 모델이 복잡한 지식을 더 잘 통합 할 때만 잘 수행됩니다. 튜닝이 접근 할 때 직접적인 대형 유닛과는 달리 단일 토큰과 달리, 우리는 튜닝이 접근 할 때 열악하지는 않지만, 우리는 spe-semantic 단위에 초점을 맞추지 않습니다 (예 : 다중 점점 Cific 과제는 더 복잡하고 대신 일반적인 선명 기업 또는 사건을 제안합니다. 대규모 최종 국가 및 사건 (Bach, 1986; Araki and Mitamura, Ity Knowledge Graph Aser, 우리는 성공적으로 2018). 예를 들어, 표 1에서 볼 수 있듯이, 우리가 미리 훈련 된 언어 모델 (즉, Bert는 Lama (Petroni et al., 2019)를 따라 가르쳐서 풍부한 담론 수준의 공통점 …

출처(Source): arXiv.org (또는 해당 논문의 원 출처)

답글 남기기